La nueva frontera digital: cuando la realidad ya no es confiable

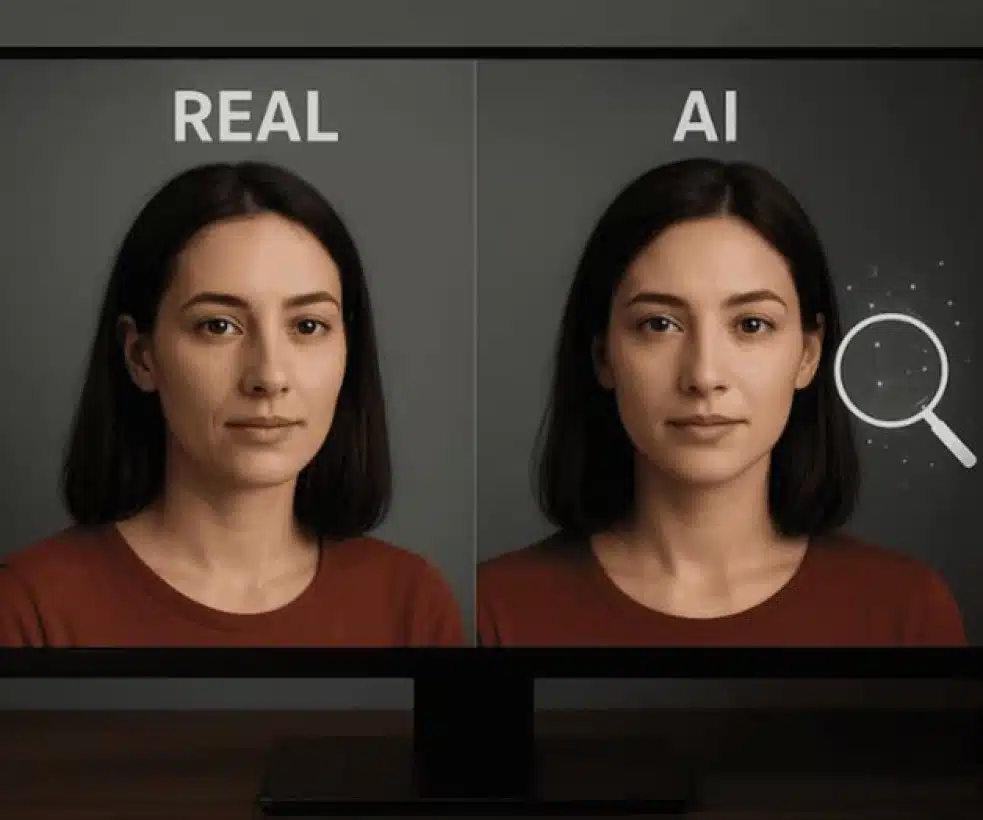

Llevo años inmerso en el mundo de la tecnología, y nunca había visto un cambio tan vertiginoso como el que estamos viviendo con la inteligencia artificial. Recuerdo la primera vez que un colega me mostró un “deepfake” hace unos años; era tosco, fácil de detectar. Hoy, la sofisticación es tal que incluso un ojo entrenado puede dudar. Esta evolución ha abierto la caja de Pandora de los riesgos digitales, transformando la desinformación en una amenaza hiperrealista.

En mi experiencia, el verdadero peligro no es la tecnología en sí, sino la complacencia del usuario. He asesorado a comunicadores y artistas en México que han visto sus identidades suplantadas con una precisión aterradora. La lección más valiosa que puedo compartir es esta: la alfabetización digital ya no es opcional, es tu primer y último escudo contra el engaño.

El arte de detectar lo artificial: lecciones desde la trinchera

La teoría nos dice que los deepfakes utilizan redes neuronales. La práctica, ganada tras analizar cientos de casos, nos enseña a buscar los “deslices” digitales. Las redes neuronales son brillantes, pero aún no dominan la sublime imperfección de lo biológico.

He compilado una lista de señales basada en errores recurrentes que he documentado:

- Anatomía improbable: La IA suele fallar en la simetría y las proporciones. Observa siempre las manos: a menudo tienen dedos de más o contornos antinaturales. Los ojos pueden carecer de la profundidad real y los dientes parecer una hilera perfecta y poco creíble.

- Iluminación incoherente: La física de la luz es un desafío. He visto retratos donde las sombras en el rostro no coinciden con la dirección de la luz en el fondo. Los reflejos en los ojos a veces muestran escenas que no existen en el entorno.

- Expresiones faciales robóticas: El parpadeo es un marcador clave. Los humanos parpadeamos de forma natural e irregular. En muchos sintéticos, el parpadeo es lento, espaciado de forma mecánica o simplemente ausente. La sincronización labial también suele ser imperfecta.

- Entornos inestables: El fondo es el gran olvidado. Los objetos pueden fundirse, cambiar de forma entre fotogramas o desaparecer sin una transición lógica. Es como un escenario de teatro que se desmonta a los leves.

- Voces sin alma: La clonación vocal ha mejorado, pero aún carece de las microvariaciones emocionales. Una voz sintética mantiene un tono uniforme, sin las pausas naturales, los suspiros o los leves cambios de ritmo que delatan a un ser humano.

- Procedencia sospechosa: La regla de oro que repito siempre: investiga la fuente. Si un contenido impactante solo aparece en un perfil nuevo o anónimo, es una bandera roja gigante. La confiabilidad del emisor es el 50% de la verificación.

Protocolo de verificación: más allá del ojo humano

Confiar solo en la percepción es un error que he cometido. Hoy, combino el instinto con herramientas concretas. Mi protocolo personal implica:

- Búsqueda inversa de imagen: Antes de compartir cualquier cosa, uso motores como Google Lens o TinEye. En más de una ocasión, he descubierto que una “nueva” imagen era un fotomontaje de una foto antigua.

- Análisis de la fuente: ¿Es un medio serio? ¿La cuenta tiene historial y engagement orgánico? Los perfiles falsos suelen tener poca actividad previa y un crecimiento acelerado y artificial.

- Contraste con el contexto informativo: Si un evento es real, múltiples fuentes lo cubrirán. La exclusividad absoluta de una notía explosiva es, casi siempre, sinónimo de fabricación.

- Inspección de metadatos: Aunque no es infalible, revisar los datos EXIF de una imagen puede revelar sorpresas, como un software de generación por IA o una fecha de creación incongruente.

Además, hoy contamos con detectores especializados. Herramientas como Winston AI o Deepware analizan patrones forenses a nivel de píxel, buscando las huellas digitales que la IA deja en su creación. Son un complemento valioso, pero no un reemplazo del criterio humano.

Reflexión final: por qué esta batalla nos define

El impacto trasciende lo individual. He trabajado con actores de doblaje cuya voz fue clonada para estafas, y he visto cómo la confianza pública se erosiona. Esto no se trata solo de no caer en un engaño; se trata de proteger el valor de la verdad, la integridad del trabajo artístico y el derecho a una identidad propia.

La educación digital se ha convertido en la habilidad crítica de nuestro tiempo. Aprender a discernir lo real de lo sintético no es una cuestión técnica, es un acto de defensa personal en la era de la información. La batalla contra la desinformación automatizada se gana con ojos críticos, herramientas adecuadas y una dosis saludable de escepticismo. Es la lección más importante que la experiencia me ha dado.